Рассказываем, как за относительно небольшой срок нам удалось добиться существенных результатов в продвижении сайта, к которому ранее слово SEO не имело абсолютно никакого отношения.

Задача статьи — не только продемонстрировать пример того, как всё может быть здорово и замечательно, но и дать возможность читателям самостоятельно повторить на собственных проектах всё то, что было выполнено с нашей стороны. А чтобы вам было проще это сделать, мы подобрали обучающие видео с нашего YouTube-канала, которые подробно описывают каждый этап проведенных нами работ (почти около каждого пункта стоит номер, по которому можно найти соответствующее обучающие видео в таблице №2, ближе к концу статьи).

В этом кейсе речь пойдет про сайт юридических услуг и про то, как попасть в ТОП-1 по ключевым направлениям и существенно увеличить трафик, не имея изначально ничего.

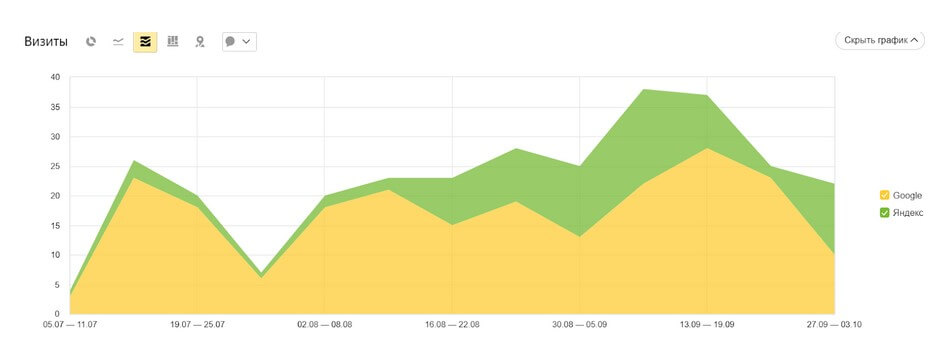

Проект пришел в начале июля 2021 года. На тот момент ни о каких позициях и трафике речи не шло. Требовались быстрые внедрения по приоритетным услугам, а также следовало срочно привести сайт в достойный вид как с визуальной точки зрения, так и с точки зрения его структуры.

Каков секретный соус?

Хотелось бы сразу отметить, что ничего выдающегося и секретного мы не проворачивали. Мы выполняли самые стандартные работы, приправив их нашим вниманием, ответственностью и желанием услышать клиента.

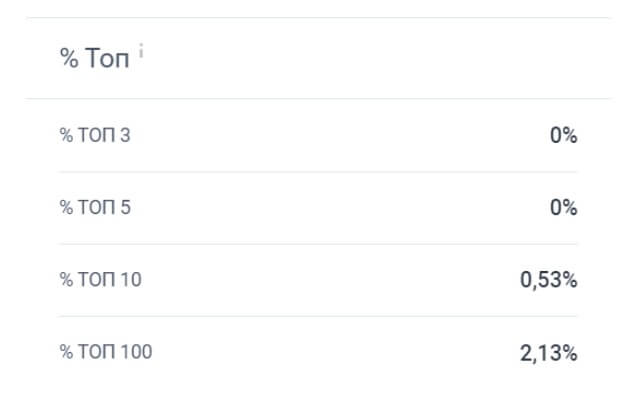

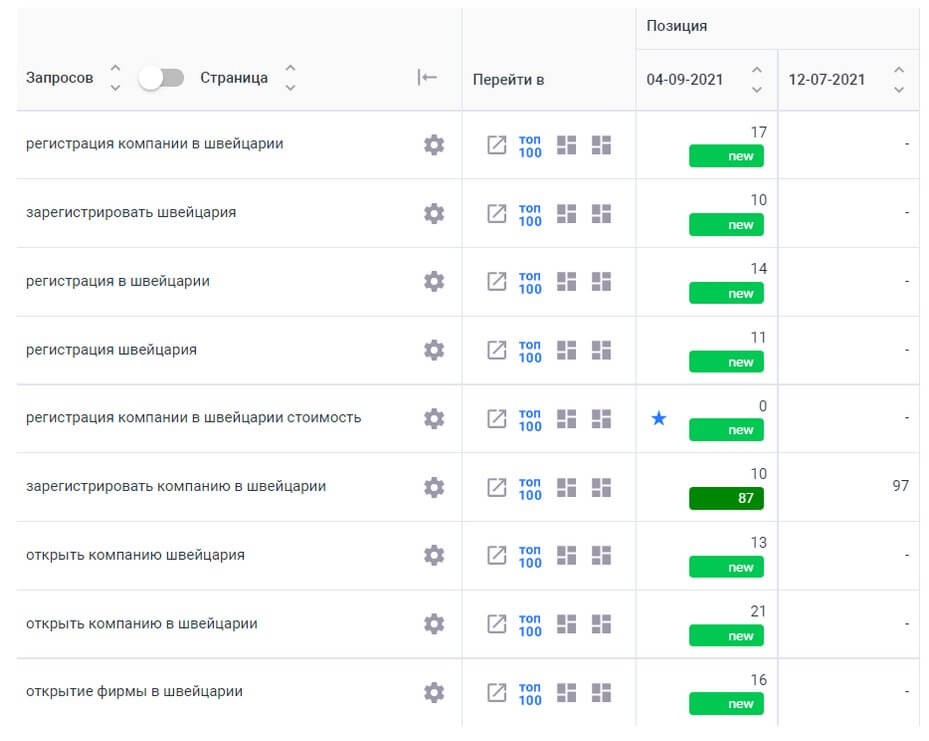

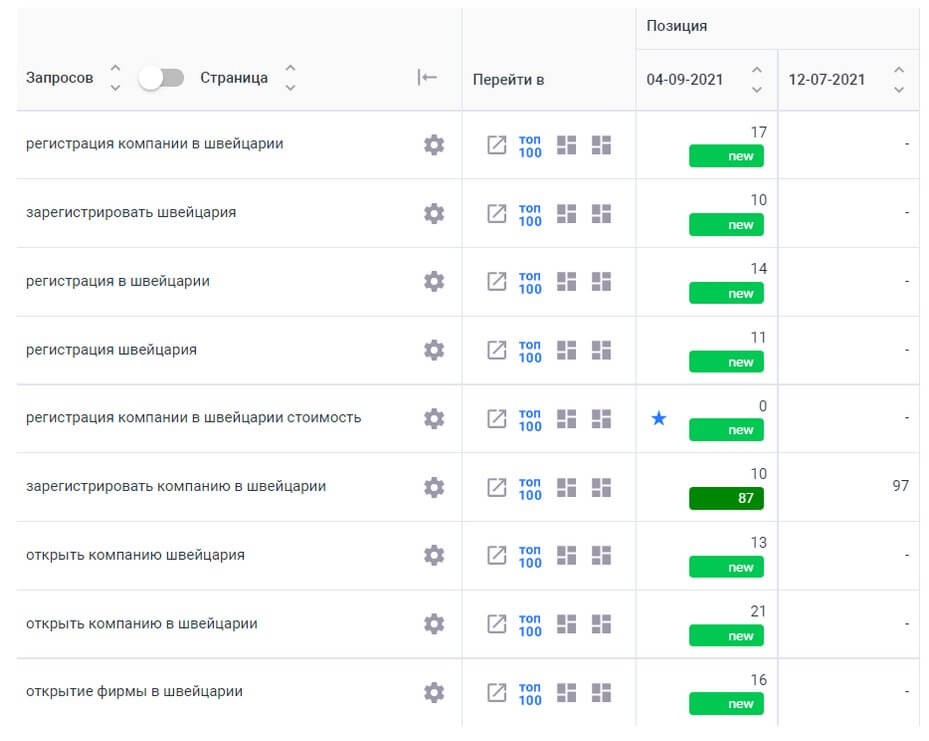

Изначально было так (рисунки 2, 3, 4).

Показатели были далеко не впечатляющими, а значит, предстояла активная комплексная работа по развитию и оптимизации сайта.

Крадущийся тигр. Первые шаги

В качестве приоритетов на старте работ мы выделили коммерческие и текстовые факторы. Но не забыли и про технические факторы, взяв в работу только самые серьезные проблемы, коих, к счастью, оказалось не так уж и много.

Что было сделано в первый месяц?

- Собрано семантическое ядро для приоритетного направления. Выполнена кластеризация (здесь и далее номер обучающего видео о том, как это сделать самостоятельно: №1, №2).

- Составлены ТЗ на контент, написаны и размещены тексты (№3).

- Выполнен YMYL-аудит страницы услуг и общих элементов исходя из анализа конкурентов (№7).

- Составлено ТЗ дизайнеру по отрисовке новых блоков (№8).

- Выполнен краткий технический аудит сайта (№4).

- Составлено ТЗ программисту на исправление технических ошибок (№4).

Что было сделано за второй месяц?

- Внедрены новые блоки на сайт после отрисовки дизайнером.

- Подготовлены ТЗ на дизайн под главную страницу и страницу “Сотрудники” с последующей реализацией (№8).

- Доработаны технические ошибки (№4).

- Скорректированы метатеги.

- Проведены усиленные работы с контентом для приоритетных направлений бизнеса (№1, №2, №3).

- Созданы новые посадочные страницы.

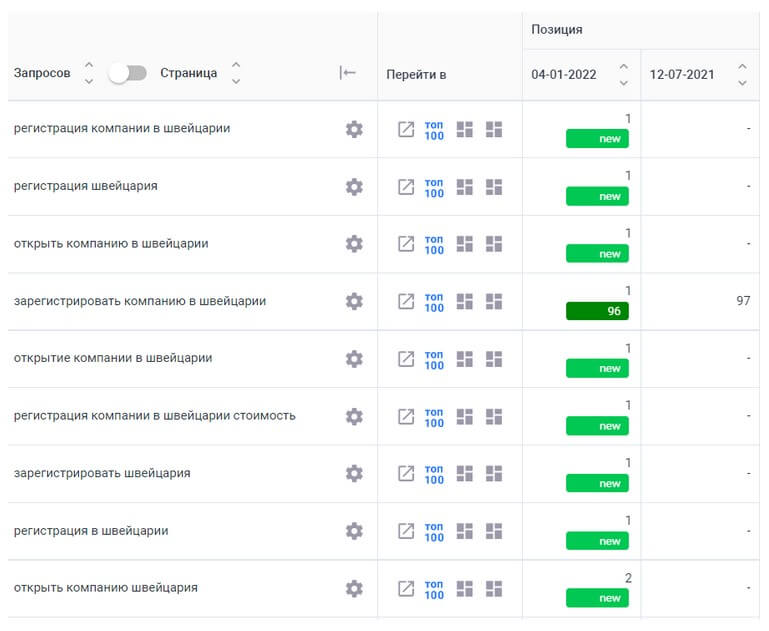

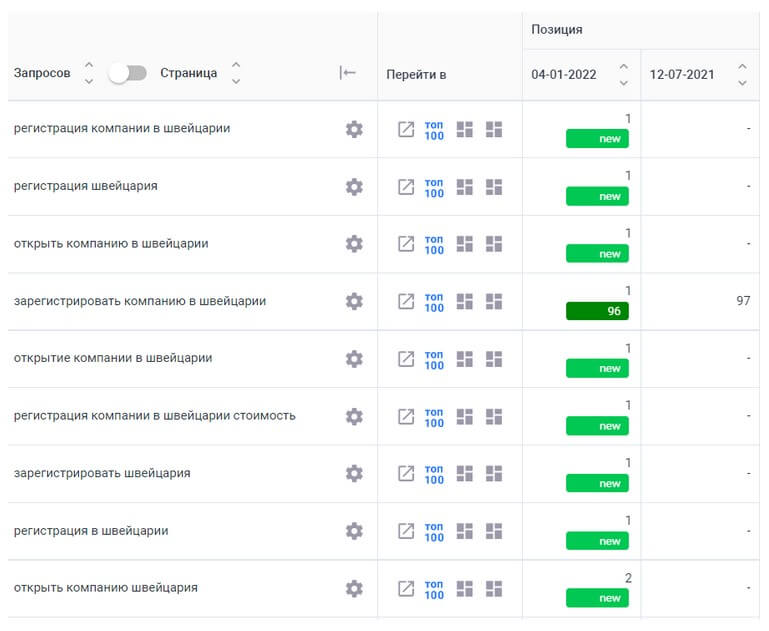

Результатом по приоритетному направлению после быстрых внедрений стало попадание сайта в ТОП-20 по главной услуге компании через 2 месяца и в ТОП-1 через полгода.

А что дальше?

В последующие периоды мы проводили ряд стандартных работ для комплексного продвижения сайта. Вот некоторые из них:

- Расширение семантического ядра для последующих направлений (№1, №2).

- Создание новых посадочных страниц под услуги (№3).

- YMYL-аудит страниц с контактами и сотрудниками (№7).

- Работы с микроразметкой (№5).

- Закупка ссылок (№9).

- Работы с оптимизацией скорости загрузки страниц сайта.

- Многое другое

Шло время, результатами был доволен как клиент, так и мы. Но на этом никто и не думал останавливаться. К тому же не всё было настолько гладко, как хотелось бы…

В Яндексе дела обстояли уже довольно хорошо, и мы закрепились по ряду приоритетных кластеров в ТОП-1. А Google хоть и показывал рост, но это было несопоставимо с успехами в Яндексе.

Понимая это, мы приняли решение сделать акцент на работах для Google:

- закупка ссылок;

- работы с YouTube;

- размещение отзывов и комментариев на форумах;

- размещение ссылок в тематических Telegram-каналах.

И… получилось! 😁

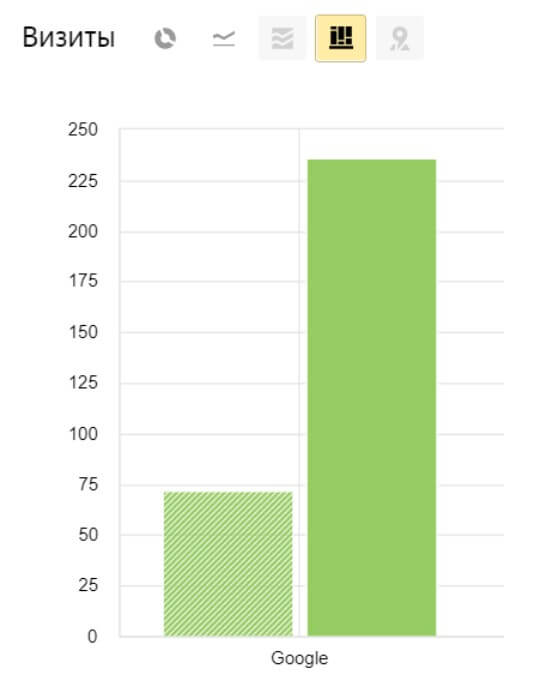

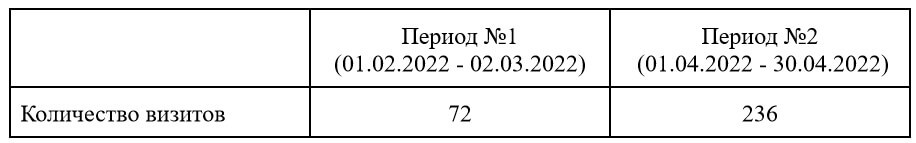

Ниже приведено сравнение по трафику и позициям в Google с февраля 2022 по апрель 2022 включительно (рисунки 11, 12, таблица №1).

Таблица №1. Количество визитов в Google.

А вот и причина роста в Google (рисунок 13).

Также с апреля начали увеличиваться показатели конверсии по каналу YouTube, что тоже имело положительное влияние.

Теперь для полноты картины вернемся к Яндексу.

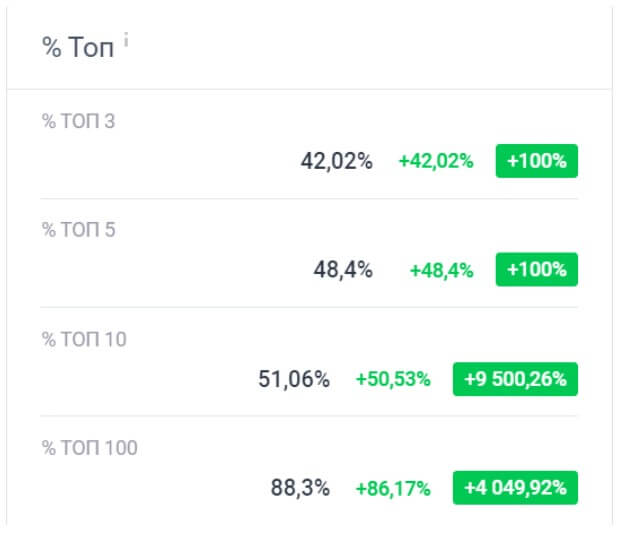

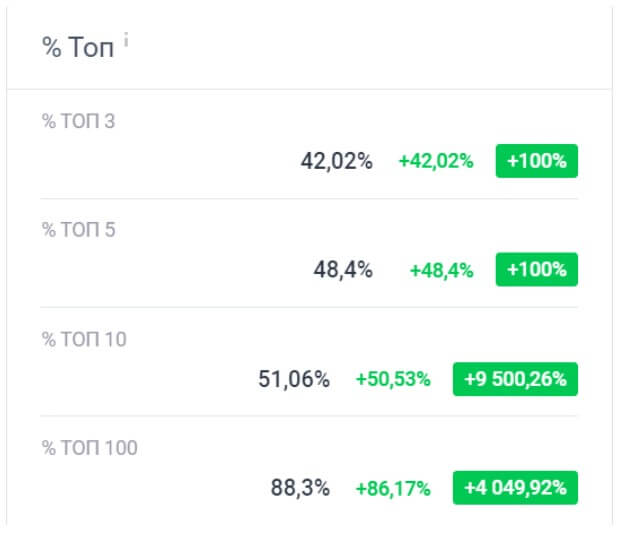

По трафику и ключевому направлению всё достаточно хорошо. А что же по позициям в целом? Ситуацию можем наблюдать на рисунках 15 и 16.

По итогу к марту-апрелю 2022 года мы имели хорошую динамику развития сайта как по позициям, так и по трафику и в Google, и в Яндекс.

Работа кипела, мы видели конкретные точки роста для проекта, имели общее видение ситуации и перспектив с клиентом, но… К этому времени ситуация в мире существенно изменилась. Работы по проекту были остановлены, поскольку бизнес был практически полностью ориентирован на работу с европейскими странами.

План победных действий

Чтобы вам было проще понять, что именно мы делали с сайтом и как можно самостоятельно это повторить, представляем выкладку с полезными образовательными материалами от нашей команды по каждому из этапов работ.

Таблица №2. Обучающие материалы.

Еще больше полезных обучающих видео по SEO вы найдете на нашем YouTube-канале. Подписывайтесь, чтобы ничего не пропустить.

Занавес

В заключение хочется подчеркнуть, что для проекта не прорабатывалась сверхдетальная, уникальная, непревзойденная вовек, в граните высеченная стратегия продвижения. Специалисты просто выполняли свою работу, показав, что SEO — не всегда что-то сложное и запутанное. Достаточно делать свою работу хотя бы с малой толикой энтузиазма.

Всем трафика 😉

Автор: Максим Галансков (Ant-Team.ru)

P.s. Подписывайтесь на наш телеграм-канал t.me/seoantteam, чтобы первыми узнавать о выходе новых полезных материалов. Там мы регулярно публикуем кейсы и видеоуроки по SEO.